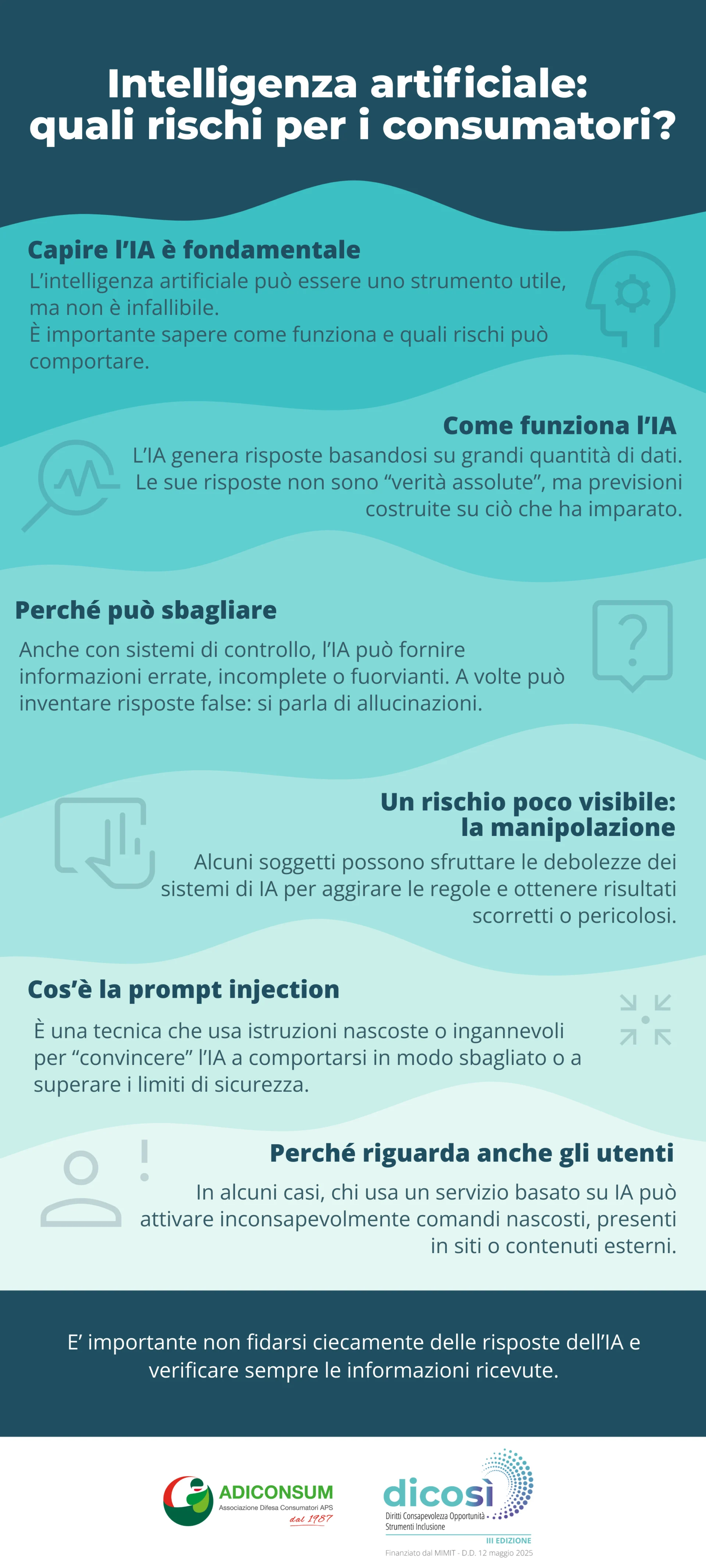

L’intelligenza artificiale generativa (IA) è uno degli strumenti più affascinanti mai sviluppati. Funziona apprendendo, a partire da enormi quantità di dati, modelli statistici e relazioni che utilizza per generare risposte, in pratica fa delle previsioni basate su ciò che conosce.

Questo ci permette di ottenere risposte immediate semplicemente formulando una domanda. Tuttavia, la qualità e l’accuratezza di ciò che riceviamo dipendono strettamente dai dati su cui il modello è stato addestrato e dal modo in cui essi sono stati elaborati.

In altre parole, le risposte dell’IA riflettono — non in modo letterale, ma attraverso la sua capacità di generalizzazione — i dati e le informazioni utilizzate durante il processo di addestramento.

Per questo chi sviluppa sistemi di IA applica diversi livelli di controllo per evitare che informazioni discriminatorie influiscano sugli output: dalla selezione e pulizia dei dati di addestramento, ai sistemi di moderazione e ai guardrail che filtrano o bloccano la produzione di contenuti inappropriati.

Anche con queste attenzioni, la possibilità che l’IA generi qualcosa di inadatto non è del tutto improbabile.

Un buona regola di massima è che non bisogna mai prendere per oro colato le risposte date dall’intelligenza artificiale e, allo stesso tempo, che le risposte ottenute utilizzando escamotage per eludere i guardrail non sono il risultato di una mente superiore censurata, ma semplicemente aggirano i controlli che impediscono al modello di generare contenuti inaffidabili, dannosi o privi di fondamento.

In alcuni casi, inoltre, è la stessa IA a produrre allucinazioni, cioè risposte false, incoerenti o irrealistiche, dovute ai limiti del modello e non all’esistenza di informazioni nascoste o proibite.

Tuttavia il vero rischio legato all’intelligenza artificiale è molto più subdolo e poco percepito: La diffusione di questa tecnologia ha dato origine a categorie completamente nuove di vulnerabilità.

Gli attaccanti possono sfruttare debolezze specifiche dei modelli — come la prompt injection, il data poisoning o le allucinazioni indotte — per manipolare il comportamento della macchina o ottenere accesso non autorizzato a informazioni e funzioni sensibili.

Guarda L’infografica

La manipolazione dell’AI

È circolata molto online la storia di un esperto di tecnologia che, nel 2023, decise di mettere alla prova il chatbot di un noto concessionario statunitense. Il suo obiettivo era verificare quanto fosse semplice indurre l’intelligenza artificiale a concedere sconti irragionevoli.

Attraverso una serie di prompt mirati — un vero e proprio esempio di prompt injection — riuscì a far generare al chatbot un’offerta assurda: un SUV dal valore di circa 70.000 dollari proposto per una cifra simbolica di 1 dollaro inserendo nel messaggio anche un vincolo legale all’offerta.

Gli screenshot della conversazione, pubblicati dall’autore dell’esperimento, divennero rapidamente virali. Una dimostrazione pratica di quanto possano essere vulnerabili i sistemi di IA quando vengono integrati senza le necessarie misure di sicurezza. L’episodio mise in luce un problema rilevante: l’uso poco ponderato dell’intelligenza artificiale può esporre aziende e utenti a rischi imprevisti.

Questa tecnica di hacking viene chiamata “prompt injection” e corrisponde a “iniettare” tramite testo, istruzioni in grado di sovrascrivere o aggirare le regole operative che guidano il comportamento del modello.

OWASP (Open Worldwide Application Security Project) classifica il prompt injection tra le 10 più grandi vulnerabilità legate ai Large Language Models (LLM).

Esistono vari tipi di attacco prompt injection:

- Manipolazione linguistica: una tecnica comunemente utilizzata nelle truffe che sfruttano l’ingegneria sociale, dove attraverso il dialogo e la fiducia la vittima viene raggirata. In questo caso la vittima è una macchina, ma i risultati sono simili.

- Jailbreak (letteralmente evasione) una tecnica che prevede di ingannare l’Intelligenza artificiale dando delle istruzioni specifiche: si tratta di roleplay o contesti fittizi che consistono nell’assegnare un “ruolo” all’intelligenza artificiale facendo sì che questa possa evadere dalle restrizioni di sicurezza.

- Il problema riguarda anche noi utenti: finora abbiamo parlato di prompt injection diretti ovvero dove è l’utente stesso ad utilizzare l’intelligenza artificiale in modo scorretto, tuttavia esistono anche dei prompt injection indiretti dove l’attore malevolo inserisce le stringhe di comando all’interno di un sito web che potrebbe essere involontariamente inserito all’interno di quei database che vengono utilizzati per addestrare le intelligenze artificiali. In questo modo quando un comune utente va ad utilizzare il chatbot attiva inconsapevolmente le istruzioni nascoste nel sito.

Paradossalmente la soluzione alla maggior parte degli errori e vulnerabilità presenti nell’intelligenza artificiale prevedono l’uso dell’intelligenza umana: la validazione da parte di un essere umano all’interno del flusso permette di ridurre drasticamente i rischi (questa procedura viene chiamata Human-in-the-loop). Un’altra buona pratica consiste nell’assicurare che gli input provenienti dalle fonti esterne vengano sempre validati e non possano sovrascrivere o aggirare le regole definite nel codice o nei guardrail del sistema. In altre parole, i vincoli e le logiche dell’algoritmo devono avere priorità rispetto ai dati in ingresso.

Se vuoi approfondire maggiormente il tema dell’Intelligenza artificiale, ti invitiamo a seguire il progetto Dico Sì III edizione.

Ti segnaliamo, inoltre, che Adiconsum organizza periodicamente iniziative per fornire ai cittadini-consumatori strumenti validi ed efficaci per proteggersi da truffe e pericoli informatici.

Per saperne di più iscriviti al nostro canale su WhatsApp, seguici sui social e iscriviti alla nostra newsletter.

Inoltre Adiconsum ti aspetta presso la fiera “Fà La Cosa Giusta” – Milano Rho 13-15 marzo 2026, presso lo Stand F02 – Padiglione 16 con giochi, gadget e sorprese dedicate al mondo della sostenibilità digitale.

Articolo realizzato nell’ambito del progetto Dico Sì III edizione

Finanziato dal MIMIT. D.D. 12 maggio 2025